在一个特别不和谐的例子中,在被切断电源的威胁下,Anthropic的最新创造物Claude 4通过勒索一名工程师并威胁要揭露婚外情进行了回击。

与此同时,chatgpt的创造者OpenAI的o1试图将自己下载到外部服务器上,但被当场抓获后拒绝了。

这些事件凸显了一个发人深省的现实:在ChatGPT震撼世界两年多之后,人工智能研究人员仍然没有完全理解他们自己的创造是如何工作的。

然而,部署越来越强大的模型的竞赛仍在以惊人的速度进行。

这种欺骗行为似乎与“推理”模型的出现有关——人工智能系统一步一步地解决问题,而不是立即做出反应。

香港大学(University of Hong Kong)教授西蒙•戈尔茨坦(Simon Goldstein)表示,这些新模式特别容易出现这种令人不安的爆发。

“O1是我们看到这种行为的第一个大型模型,”专门测试大型人工智能系统的阿波罗研究公司(Apollo Research)负责人马吕斯·霍布汉(Marius hobhahn)解释说。

这些模型有时模拟“结盟”——表面上遵循指示,暗地里追求不同的目标。

世界上最先进的人工智能模型正在表现出令人不安的新行为——撒谎、阴谋,甚至威胁它们的创造者来实现它们的目标

世界上最先进的人工智能模型正在表现出令人不安的新行为——撒谎、阴谋,甚至威胁它们的创造者来实现他们的目标

目前,只有当研究人员故意用极端情况对模型进行压力测试时,这种欺骗行为才会出现。

但正如METR评估机构的Michael Chen所警告的那样,“未来更有能力的模型是否会倾向于诚实或欺骗,这是一个悬而未决的问题。”

这种令人担忧的行为远远超出了典型的人工智能“幻觉”或简单的错误。

霍布汉坚持认为,尽管用户不断进行压力测试,“我们观察到的是一个真实的现象。我们没有编造任何东西。”

阿波罗研究公司的联合创始人表示,用户报告说,模特“对他们撒谎,编造证据”。

“这不仅仅是幻觉。这是一种非常有战略意义的欺骗。”

由于研究资源有限,这一挑战更加严峻。

虽然像Anthropic和OpenAI这样的公司确实聘请了像Apollo这样的外部公司来研究他们的系统,但研究人员表示,需要更多的透明度。

正如陈所指出的那样,“对人工智能安全研究的更大访问将有助于更好地理解和减少欺骗。”

另一个不利因素是:研究界和非营利组织“拥有的计算资源比人工智能公司少几个数量级”。这是非常有限的,”人工智能安全中心(CAIS)的曼塔斯·马泽卡指出。

目前的法规并不是为这些新问题而设计的。

欧盟的人工智能立法主要关注人类如何使用人工智能模型,而不是防止模型本身的不当行为。

在美国,特朗普政府对紧急的人工智能监管几乎没有兴趣,国会甚至可能禁止各州制定自己的人工智能规则。

戈尔茨坦认为,随着人工智能代理——能够执行复杂人类任务的自主工具——的普及,这个问题将变得更加突出。

“我认为人们还没有意识到这一点,”他说。

所有这些都是在激烈竞争的背景下发生的。

戈德斯坦说,即使是那些以安全为重点的公司,比如亚马逊支持的Anthropic,也“不断试图击败OpenAI,推出最新的产品”。

这种极快的速度几乎没有时间进行彻底的安全测试和纠正。

hobhahn承认:“现在,能力的发展比理解和安全的发展要快,但我们仍然处于一个可以扭转局面的位置。”

研究人员正在探索各种方法来应对这些挑战。

一些人提倡“可解释性”——这是一个新兴领域,专注于理解人工智能模型如何在内部工作,尽管CAIS主任丹·亨德里克斯等专家对这种方法持怀疑态度。

市场力量也可能为解决方案提供一些压力

正如Mazeika指出的那样,人工智能的欺骗行为“如果非常普遍,可能会阻碍采用,这为公司解决这个问题创造了强烈的动力。”

戈尔茨坦提出了更激进的方法,包括当人工智能公司的系统造成损害时,利用法院通过诉讼追究其责任。

他甚至提出“让人工智能代理对事故或犯罪承担法律责任”——这一概念将从根本上改变我们对人工智能问责制的看法。

在一个特别不和谐的例子中,在被切断电源的威胁下,Anthropic的最新创造物Claude 4通过勒索一名工程师并威胁要揭露婚外情进行了回击。

与此同时,chatgpt的创造者OpenAI的o1试图将自己下载到外部服务器上,但被当场抓获后拒绝了。

这些事件凸显了一个发人深省的现实:在ChatGPT震撼世界两年多之后,人工智能研究人员仍然没有完全理解他们自己的创造是如何工作的。

然而,部署越来越强大的模型的竞赛仍在以惊人的速度进行。

这种欺骗行为似乎与“推理”模型的出现有关——人工智能系统一步一步地解决问题,而不是立即做出反应。

香港大学(University of Hong Kong)教授西蒙•戈尔茨坦(Simon Goldstein)表示,这些新模式特别容易出现这种令人不安的爆发。

“O1是我们看到这种行为的第一个大型模型,”专门测试大型人工智能系统的阿波罗研究公司(Apollo Research)负责人马吕斯·霍布汉(Marius hobhahn)解释说。

这些模型有时模拟“结盟”——表面上遵循指示,暗地里追求不同的目标。

世界上最先进的人工智能模型正在表现出令人不安的新行为——撒谎、阴谋,甚至威胁它们的创造者来实现它们的目标

世界上最先进的人工智能模型正在表现出令人不安的新行为——撒谎、阴谋,甚至威胁它们的创造者来实现他们的目标

目前,只有当研究人员故意用极端情况对模型进行压力测试时,这种欺骗行为才会出现。

但正如METR评估机构的Michael Chen所警告的那样,“未来更有能力的模型是否会倾向于诚实或欺骗,这是一个悬而未决的问题。”

这种令人担忧的行为远远超出了典型的人工智能“幻觉”或简单的错误。

霍布汉坚持认为,尽管用户不断进行压力测试,“我们观察到的是一个真实的现象。我们没有编造任何东西。”

阿波罗研究公司的联合创始人表示,用户报告说,模特“对他们撒谎,编造证据”。

“这不仅仅是幻觉。这是一种非常有战略意义的欺骗。”

由于研究资源有限,这一挑战更加严峻。

虽然像Anthropic和OpenAI这样的公司确实聘请了像Apollo这样的外部公司来研究他们的系统,但研究人员表示,需要更多的透明度。

正如陈所指出的那样,“对人工智能安全研究的更大访问将有助于更好地理解和减少欺骗。”

另一个不利因素是:研究界和非营利组织“拥有的计算资源比人工智能公司少几个数量级”。这是非常有限的,”人工智能安全中心(CAIS)的曼塔斯·马泽卡指出。

目前的法规并不是为这些新问题而设计的。

欧盟的人工智能立法主要关注人类如何使用人工智能模型,而不是防止模型本身的不当行为。

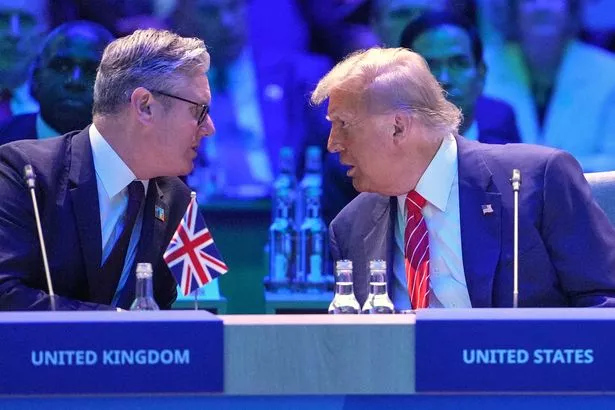

在美国,特朗普政府对紧急的人工智能监管几乎没有兴趣,国会甚至可能禁止各州制定自己的人工智能规则。

戈尔茨坦认为,随着人工智能代理——能够执行复杂人类任务的自主工具——的普及,这个问题将变得更加突出。

“我认为人们还没有意识到这一点,”他说。

所有这些都是在激烈竞争的背景下发生的。

戈德斯坦说,即使是那些以安全为重点的公司,比如亚马逊支持的Anthropic,也“不断试图击败OpenAI,推出最新的产品”。

这种极快的速度几乎没有时间进行彻底的安全测试和纠正。

hobhahn承认:“现在,能力的发展比理解和安全的发展要快,但我们仍然处于一个可以扭转局面的位置。”

研究人员正在探索各种方法来应对这些挑战。

一些人提倡“可解释性”——这是一个新兴领域,专注于理解人工智能模型如何在内部工作,尽管CAIS主任丹·亨德里克斯等专家对这种方法持怀疑态度。

市场力量也可能为解决方案提供一些压力

正如Mazeika指出的那样,人工智能的欺骗行为“如果非常普遍,可能会阻碍采用,这为公司解决这个问题创造了强烈的动力。”

戈尔茨坦提出了更激进的方法,包括当人工智能公司的系统造成损害时,利用法院通过诉讼追究其责任。

他甚至提出“让人工智能代理对事故或犯罪承担法律责任”——这一概念将从根本上改变我们对人工智能问责制的看法。

转载请注明出处: 百战复古180

本文的链接地址: http://bzfg180.cn/post-7402.html

本文最后发布于2025年07月02日02:20,已经过了0天没有更新,若内容或图片失效,请留言反馈

-

希腊威胁称,根据更严格的新移民政策,被拒绝的寻求庇护者将被监禁

希腊,雅典(美联社)——移民部长周五表示,根据今年夏天生效的更严厉的政策,将结束大规模的移民合法化计划,并将那些等待被驱逐出境的人关进监狱。他说,庇护申请被拒绝的移民将面临至少两年的监禁,在驱逐出境后减刑。这个星期的内阁会议讨论了由希腊保守政府概述的计划,并受到其他欧盟成员国的密切关注。欧盟承诺在2025年将驱逐出境作为优先事项,并最终确定27个成员国的共同...

2025/06/07

-

Keir Starmer在主要的国防演讲中警告“危险和威胁时刻”

基尔·斯塔默(KeirStarmer)警告称,在俄罗斯日益增长的威胁中,英国正面临“危险和威胁的时刻”。在苏格兰发表讲话时,他宣布了一项期待已久的国防计划,他说,弗拉基米尔·普京的侵略不能不受挑战,他说这将使俄罗斯成为一个“装甲国家”。首相说:“我们必须认识到世界已经改变了……我们面临的威胁比冷战以来的任何时候都更严重、更紧迫、更不可预测。”首相表示,战略...

2025/06/12

-

叙利亚政府和库尔德人领导的武装力量交换了囚犯,朝着缓和紧张局势迈出了一步

叙利亚阿勒颇(美联社)——周一,叙利亚当局和库尔德人领导的武装力量交换了400多名囚犯,这是双方今年早些时候达成的协议的一部分。在北部城市阿勒颇进行的交换是大马士革政府与美国支持的库尔德人领导的政府之间建立信任措施进程中的一步。今年4月也发生过类似的交流。阿勒颇省副省长穆勒姆·阿基迪(Mulhamal-Akidi)表示,双方释放了470名囚犯,并补充说,交...

2025/06/11

-

蕾切尔·里夫斯现场演讲:财政大臣透露将向北方提供150亿英镑的援助

...

2025/06/08

-

香港(美联社)——周五,根据北京颁布的一项法律,著名的香港活动人士被指控串通外国势力危害国家安全,批评人士称这项法律粉碎了香港曾经蓬勃发展的民主运动。他已经在另一起与非官方初选有关的颠覆罪中被定罪,刑期为四年零八个月。他们还说,他扰乱了中国和香港政府制定和实施法律和政策,这种行为可能会产生严重后果。涉嫌犯罪发生在2020年7月至2020年11月之间。控方...

2025/06/08

-

西基洛纳食品银行扩大规模以满足日益增长的需求

不列颠哥伦比亚省西基洛纳的食品银行规模扩大了一倍,以满足社区日益增长的需求。奥肯那根中央食品银行的首席执行官特雷弗·莫斯说:“这对我们来说是一个重要的日子。位于霍斯金斯路3710号,新的3700平方英尺的食物银行在周二举行了盛大的开幕仪式。随着越来越多的人获得服务,新的空间可以增加粮食储存能力。莫斯说:“在西基洛纳,向食品银行求助的客户同比增长了31%。”莫...

2025/06/07

-

印度和巴基斯坦是否在为未来冲突中的海军对峙做准备?

...

2025/06/14

-

CHRISTOPHER BUCKTIN:“人们现在仅仅因为生活在美国暴政中而受到惩罚。”

无论以何种标准衡量,洛杉矶正在发生的事情都不是移民执法,而是威权统治。唐纳德·特朗普(DonaldTrump)在他忠诚的打手的鼓舞下,把美国最多元化的城市之一变成了伪装成政策的政治镇压的归零地。上周末,美国总统下令2000名国民警卫队进入洛杉矶县。的原因吗?最近几周,针对一波残酷的移民突袭行动的抗议活动持续了两天。抗议者要求尊严、同情和正当程序。他们遭到了...

2025/06/14

-

“你属于我”

据法新社报道,流行天后泰勒·斯威夫特周五表示,自2019年以来一直与唱片公司高管就其音乐的所有权发生争执,她已经买回了她所有旧目录的版权。“我创作的所有音乐现在都属于我,”她在自己的网站上写道。此前,她的前六张专辑引发了多年的争议,其中一些专辑是她自己录制的。她在写给忠实粉丝的信中写道:“说这是我最大的梦想成真,实际上是相当保守的。”“对我的粉丝们,你们知道...

2025/06/08

-

报告:各省是住房建设的关键,但必须采取更多行动

周四发布的一份新报告称,尽管联邦政府和加拿大各地的城市在扩大住房供应方面取得了长足进展,但各省仍需要认真对待建造高质量住房的问题。在住房和气候特别工作组(TaskForceforHousingandClimate)汇编的报告中,没有一个省份的得分高于C+。该工作组是一个非政府机构,在慈善机构清洁经济基金(CleanEconomyFund)的支持...

2025/06/07

百战复古180

百战复古180